Notice

Recent Posts

Recent Comments

Link

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

Tags

- mobilenetv1

- grefcoco dataset

- res

- grefcoco

- 딥러닝 엔트로피

- TransFuser

- E2E 자율주행

- 이미지 필터링

- transfuser++

- 논문 요약

- 객체 검출

- vlm

- object detection

- clip adapter

- gsoc 2025

- referring expression segmentation

- 1차 미분 마스크

- 엔트로피란

- clip

- gres

- blip-2

- 논문 리뷰

- gsoc

- res paper

- 원격 학습 안끊기게

- gsoc 후기

- google summer of code

- 에지 검출

- 딥러닝 목적함수

- Object detection article

Archives

- Today

- Total

My Vision, Computer Vision

[논문 요약/리뷰] LLaMA: Open and Efficient Foundation Language Models 본문

LLaMA: Open and Efficient Foundation Language Models

We introduce LLaMA, a collection of foundation language models ranging from 7B to 65B parameters. We train our models on trillions of tokens, and show that it is possible to train state-of-the-art models using publicly available datasets exclusively, witho

arxiv.org

발행일 : 2023. 02. 27.

Meta AI

Problem

- 최근, 한정된 컴퓨터 예산(Budget)에서 LLM과 데이터셋 크기에 대한 최적화 연구가 진행되었다.

- 그러나 여기에는 추론(Inference) 예산이 반영되지 않았다는 문제가 있다. 결국 LLM을 서비스할 때 중요한 것은 훈련 속도가 아니라 추론 속도이기 때문이다.

- 따라서 본 연구에서는, 작은 크기의 모델을 더 오래 학습시키는 것이 결국 추론 비용이 더 낮고, 성능이 좋을 수 있다는 것을 보여준다.

Contributions

- 모두 오픈소스로 공개되어있고, 데이터셋은 이미 공개되어 있는 소스들을 혼합해서 구축했다.

- 다양한 크기의 모델(7B~65B)을 공개하고, 13B 모델은 10배 무거운 GPT-3를 능가했다.

Methods

Dataset

- 다양한 퍼블릭 데이터셋을 혼합하여 Pre-training 데이터셋을 구축했다.

- English CommonCrawl : 웹에서 수집한 텍스트 데이터로, 비영어, 중복, 스팸 데이터 등을 필터링한 데이터셋이다.

- C4 : CommonCrawl을 고품질로 필터링한 데이터셋.

- Github : 오픈소스 코드 리파지토리 데이터셋.

- Wikipedia : 위키피디아에서 추출한 텍스트 데이터셋.

- Gutenberg and Books3 : 고전 문학 텍스트 및 전자책 데이터셋.

- ArXiv : 기술, 물리학, AI 관련 연구 문헌 데이터셋.

- StackExchange : Stack Overflow 등 Q&A 사이트에서 수집된 데이터셋.

- 이렇게 수집한 데이터셋은 총 1.4조개의 토큰으로 구성된다.

Architecture

- 모델은 총 4가지로, 모두 트랜스포머 아키텍쳐 기반이다.

- GPT3의 Pre-normalization, PaLM의 SwiGLU 활성화 함수, GPTNeo의 Rotary Embeddings, AdamW 옵티마이저 사용.

- 메모리, 시간 최적화를 위해 Causal multi-head attention 등을 사용.

- 결과적으로 65B 모델은 2048개의 A100 GPU에서 약 21일 동안 학습된다.

- 자세한 내용은 논문 참고.

Experiment

- QA 데이터셋에 대한 Zero-shot 벤치마크이다.

- GPT-3에 비해 약 13배 작은 모델인 LLaMA 13B가 성능이 더 좋다.

- 대규모 모델인 PaLM 540B 와 비교했을 때 1, 2개 밀리지만 전반적으로 더 높다.

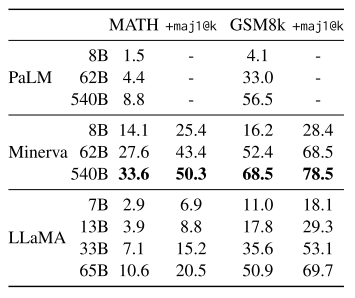

- 중, 고등 수학문제 데이터셋인 MATH와 GSM8k에 대한 벤치마크이다.

- Minerva는 ArXiv와 Math Web Pages에서 파인튜닝 한 PaLM인데, 그래서 높은 성능이 측정되었다.

- PaLM과 LLaMA는 수학 데이터셋에 파인튜닝하지 않았는데, 기본적으로 LLaMA가 PaLM보다 높다.

- 여기서 maj1@k는 한 문제에 대해 k개의 응답을 생성한 후 메이저리티 보팅(다수결 투표) 앙상블한 결과이다.

Conclusion

- LLaMA-13B는 GPT-3보다 약 13배 작은 크기에도 더 좋은 성능을 보여주었다.

- LLaMA-65B는 Chincilla-70B, PaLM-540B와 비슷한 성능이다.

- 또한 독점적인 데이터셋이 아닌 공개된 데이터셋을 사용했다.

- 더 큰 규모의 모델, 데이터셋을 사용하여 더 좋은 성능을 달성할 계획이다.

Review

- 이 연구의 기여는 모델링보다는 데이터셋에 있다.

- 공개된 데이터셋을 혼합해서 SOTA 성능을 보여주었기 때문이다.

- 아키텍처는 트랜스포머를 베이스로 했고, 활성화 함수 등 다른 부분을 주로 튜닝했다.

728x90