Notice

Recent Posts

Recent Comments

Link

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

Tags

- mobilenetv1

- grefcoco dataset

- google summer of code

- 1차 미분 마스크

- 이미지 필터링

- 딥러닝 엔트로피

- Object detection article

- object detection

- 에지 검출

- E2E 자율주행

- transfuser++

- 딥러닝 목적함수

- referring expression segmentation

- gsoc 2025

- blip-2

- 객체 검출

- 논문 요약

- clip

- 원격 학습 안끊기게

- gres

- clip adapter

- res

- gsoc

- 논문 리뷰

- vlm

- grefcoco

- TransFuser

- res paper

- 엔트로피란

- gsoc 후기

Archives

- Today

- Total

My Vision, Computer Vision

[논문 요약/리뷰] A Survey on Hallucination in Large Vision-Language Models 본문

Paper

[논문 요약/리뷰] A Survey on Hallucination in Large Vision-Language Models

gyuilLim 2025. 4. 24. 18:26A Survey on Hallucination in Large Vision-Language Models

Recent development of Large Vision-Language Models (LVLMs) has attracted growing attention within the AI landscape for its practical implementation potential. However, ``hallucination'', or more specifically, the misalignment between factual visual content

arxiv.org

Author : Liu, Hanchao, et al.

Journal : Arxiv

Keyword : Survey, Vision Langauge Model

Published Date : 2024년 2월 1일

Abstract & Introduction

- MiniGPT-4, LLaVA, LLaVA-1.5 등 유망한 LVLM(Large Vision Langauge Model) 모델들조차 환각(Hallucination) 현상은 무시할 수 없다.

- LVLM에서 환각이란 입력 이미지와 생성된 텍스트 내용 간의 불일치를 말한다. 이는 LLM(Large Langauge Model)의 텍스트 기반 환각과 유사하다.

- 객체의 존재 여부, 그러니까 모델이 객체를 정확하게 묘사했는지에 대한 환각 현상만 다루던 이미지 캡셔닝 모델과 달리, LLM을 사용한 LVLM은 환각 현상의 양상을 더 다양화하고 심화시킨다. 객체의 여부에 국한되지 않고 객체의 속성이나 관계에 대한 환각이 발생하는 것이다.

- 위의 이미지에서 처럼 환각 현상은 다양하다. 인지적 관점(Cognitive Perspective)에서 볼 때, 환각은 참/거짓 판단 오류나 시각 정보에 대한 부정확한 설명으로 나타날 수 있다.

- 예를 들어 “이미지에 고양이가 있나요?” 와 “새가 4마리인가요?” 라는 질문에 부정확하게 대답하는 것으로 사실 판단 능력(Judgement)에 결함이 있다는 것을 확인할 수 있다.

- 또한 두 번째 예시에서 이미지에 대한 설명(Description)이 실제 사진과 일치하지 않는 것을 확인할 수 있다.

- 이런 환각 현상, 다시말해 시각적 오류는 객체, 속성, 관계 세가지로 분류할 수 있다.

- 객체 : “고양이”라는 객체와 “새”라는 객체에 대한 불일치

- 속성 : 4마리, 긴 머리 등 객체의 속성에 대한 불일치

- 관계 : “파란새는 노란새 오른쪽에 있다” 같은 객체와 객체 간 관계에 대한 불일치

- 현재 환각 지표들은 두 가지 측면에 집중한다.

- Non-Hallucinatory Generation(비환각적 생성) : 모델의 응답에서 환각 요소를 분석하고 비율을 정량화

- Hallucination Discrimination(환각 구별) : 모델의 응답에서 환각이 발생했는지, 발생하지 않았는지 확인

- LVLM의 환각은 LLM의 특성 뿐만 아니라, 편향된 훈련 데이터, 이미지를 정확히 반영하지 못하는 비전 인코더의 한계, 모달리티 간의 Alignment 오류, 불충분한 Context 등이 있다.

- 이러한 원인을 바탕으로, 환각 현상을 완화하기 위한 기존의 접근 방법은 주로 훈련 데이터 최적화, LVLM의 모듈 개선, 출력 후처리 등 에 중점을 두고있다.

2. Hallucination in the Era of LVLM

2.1 Large Vision-Language Models

- LVLM은 Visual Encoder, Modality Connection Module, LLM 이렇게 세 가지로 이루어져있다.

- Visual Encoder : 보통 CLIP의 사전학습된 ViT 사용, 입력 이미지를 Visual Token으로 변환하는 역할

- Modality Coonection Module : MLP, Adapters, Q-Former등 Visual Token을 Word Embedding Space에 Align하는 역할

- LLM : Visual, Textual 정보를 활용하여 응답을 생성한다.

- LVLM의 학습은 보통 두 단계로 진행된다.

- Pre-Training : Image-Text 쌍 데이터로부터 Vision-Language 정보를 학습한다.

- Instruction-Tuning : 사람의 지시를 따르도록(ex. 이 이미지에 대해 자세히 설명해줘.) 학습한다.

- 이 과정이 완료되면 LVLM은 Visual, Textual 정보를 효율적으로 활용할 수 있게되고 VQA 같은 Multimodal Task에 적용할 수 있다.

2.2 Hallucination in LVLMs

- 다시 돌아와서 “환각”이란 우리가 사실로 취급하는 Visual Input(이미지)와 Textual Output(모델의 답변) 사이의 모순이다. 위에서 처럼, 환각 현상은 판단(Judgement) 또는 설명(Description)의 결함이라고 할 수 있다.

- Judgement Hallucination(판단 환각) : 판단 환각은 위 이미지에서 첫번째 예시처럼, 사용자의 질문에 대한 모델의 응답이 실제 시각 정보와 일치하지 않을 때 발생한다.

- Description Hallucination(설명 환각) : 설명 환각은 두번째 예시처럼 시각 정보를 충실하게 묘사하지 못하는 경우를 의미한다.

- 만약 의미론적 관점에서 본다면 위에서 설명했던 것처럼 객체, 속성, 관계에 대해 잘못 묘사/설명하는 것이라고할 수 있다. 위 이미지에서 색깔로 강조한 부분이다.

2.3 Unique Challenges regarding Hallucination in LVLMs

- LVLM은 Visual, Langauge 모듈을 모두 다루지만, 이 때문에 Hallucination Detection, Causal Inference, Mitigation Methods 등 문제가 발생한다.

Hallucination Detection Difficulties

- VLM에서 환각은 객체, 속성, 관계 등 다양한 의미적 차원에서 발생할 수 있기때문에, 탐지하기 어렵다.

- 이를 위해서는 Natural Langauge Understanding 뿐만 아니라 Fine-grained Visual Annotations, Alignment 능력이 요구된다.

Intertwined Causes

- LVLM에서 환각은 다면적인 원인(Multifaceted)에서 비롯된다.

- 환각은 잘못된 정보, 편향, 지식의 한계 등 학습 데이터로부터 영향을 받을 수 있고

- Visual Data를 통합하는, 이미지 정보의 왜곡, 불확실성에서도 영향을 받을 수 있다.

- LLM에 Vision Encoder까지 추가되었기 때문에 원인이 더 다양해졌다는 것이다.

Compound Mitigation Methods

- 이 문제를 해결하기 위해 LLM에서 사용되는 환각 완화 기법(데이터 품질 향상, 인코딩 최적화, 인간 선호 정렬 등)도 적용될 수 있고

- 시각 표현(Visual Representation)에 맞춘 새로운 해결 방법도 적용할 수 있다. 예를 들어 해상도를 높인다거나 하는 방법들이 제안되어왔다. 하지만 이는 고해상도 비전 인코더를 대규모 데이터에 학습해야하기 때문에 많은 자원이 요구되는 문제가 있다.

- 다른 방법으로는 Vision-Langauge Token 정렬, 즉 두 모달리티 사이 간극을 줄여서 환각 현상이 감소하도록 할 수 있다.

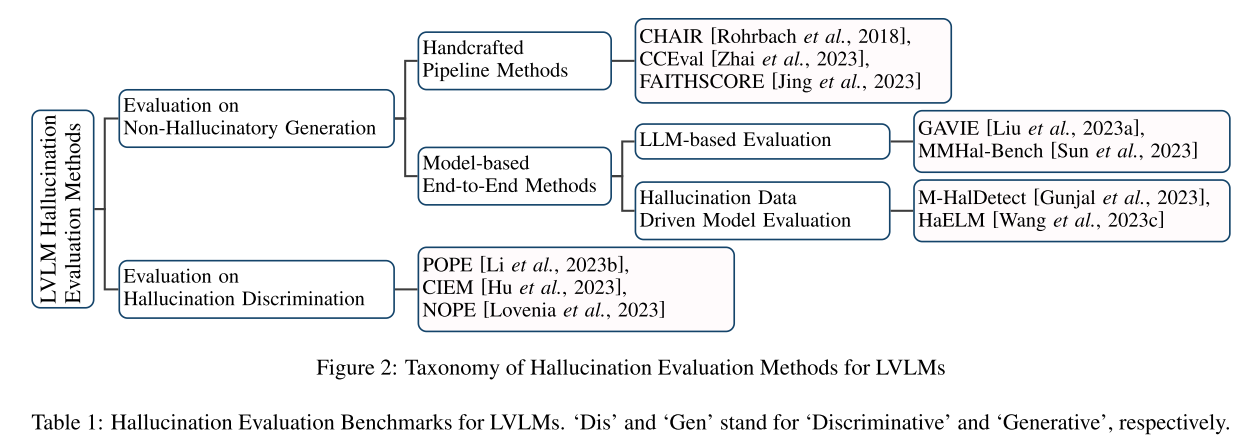

3. Evalauation Methods and Benchmarks

- 이제 LVLM의 환각 현상을 평가(Evaluation)을 어떻게 하는지, 벤치마크가 어떻게 구축되어 있는지 알아보자.

- 현재 제안된 평가 방법은 크게 두가지 범주로 나눌 수 있다.

- Assessing the model’s ability of non-hallucinatory content generation.

- Evaluating the model’s ability of hallucination discrimination.

- 마찬가지로 벤치마크도 Discriminative와 Generative로 나눌 수 있다

3.1 Evaluation on Non-Hallucinatory Generation

- 이 평가 방식은 모델의 출력에 환각이 얼마나 포함되어있는지 비율을 측정하는 것이다.

- 최근 방식에서는 Handcrafted Pipeline과 Model-based End-to-end 방법이 있다.

Handcrafted Pipeline Methods

- 이 방법은 여러 단계를 수작업으로 설계했기 때문에 높은 Interpretability(해석 가능성)를 갖는다.

- CHAIR는 이미지 캡셔닝에서 객체 환각(Object Hallucination)을 평가하는 방법인데, 모델이 생성한 캡션과 정답 캡션으로부터 객체를 추출하여 환각이 발생했는지 체크한다. 하지만 Ground-truth 캡션 내에서만 측정할 수 있는 한계가 있다.

- CCEval은 이를 해결하기 위해 GPT-4를 활용한 객체 정렬 모듈을 적용한다.

- FAITHSCORE는 위 방법들과 다르게 참조(Reference) 없이 평가하는 방식이다.

- 위 방법들은 모델의 답변으로부터 객체를 추출해야하는 과정이 필요하기때문에 Handcrafted Pipeline으로 분류된다.

Model-based End-to-End Methods

- 이 방법은 LVLM의 답변 자체를 평가한다. 기존의 End-to-End 방식은 두가지로 나눌 수 있다.

- LLM-based Evaluation : GPT-4와 같은 고성능 LLM을 활용하여 LVLM이 생성한 응답에 환각이 있는지 평가하는 것이다. 간접적인 시각 정보(바운딩 박스, 캡션)와 프롬프트를 통해 LLM이 채점기로 작동할 수 있도록 만드는 것이다.

- Hallucination Data Driven Model Evaluation : 이 방법은 환각 여부에 대해 라벨링된 데이터셋을 구축하고 LVLM을 파인튜닝하여 환각 식별용 모델을 만드는 것이다.

3.2 Evaluation on Hallucination Discrimination

- 이 방법은 LVLM이 환각을 판별할 수 있는지에 대해 평가한다. 보통 QA 형식으로, 입력 이미지와 이에 대한 진짜 질문, 가짜 질문을 입력으로 제시하고 모델의 답변을 평가한다.

- POPE는 “이미지에 [Object]가 있나요?”라는 질문을 제시하고 모델의 “YES/NO” 답변을 평가한다. 환각에 해당하는 가짜 객체는 Random, Popular, Adversarial 샘플링을 통해 구성한다.

- CIEM은 샘플링 과정을 ChatGPT로 자동화한다.

- NOPE은 답변에 부정(Negative)형 단어가 포함되어있는지 평가한다.

3.3 Evaluation Benchmarks

- Science QA, VQA v2 등 LVLM의 전반적인 성능을 평가하는 표준 벤치마크와 달리, Hallucination 벤치마크는 LVLM의 비환각 생성과 환각 판별을 목표로 한다.

- 평가 방식에 따라 판별형(Discriminative)와 생성형(Generative)로 나뉜다.

Discriminative Benchmarks

- 위에서 언급했던 POPE, CIEM, NOPE는 모두 판별형 벤치마크이다.

- 모두 객체 환각(Object Hallucination)을 타겟으로 Accuracy를 측정한다.

- 해당 이미지에 특정 객체가 존재하는지 질문하고 정답과 오답을 카운트하는 것이다.

Generative Benchmarks

- 판별형 벤치마크가 객체 수준에서의 환각에 집중하는 반면, 생성형 벤치마크는 객체뿐만 아니라 속성(Attribute)과 관계(Relation)을 포함한 범위를 다룬다.

- ABMER는 판별형과 생성형을 모두 포함한 벤치마크로 주목받고있다.

- 하지만 생성형 벤치마크에서는 모델이 생성한 답변을 바탕으로 특정 환각 유형에 대해 분석해야 하기 때문에 평가 지표가 더 복잡하고 다양해지는 경향이 있다.

4. Causes of LVLM Hallucinations

- LVLM에서 Hallucination은 다양한 원인으로부터 발생하는데, 밑의 파이프라인과 관련해서 나눌 수 있다.

4.1 Hallucinations from Data

- 학습 데이터는 모델 퍼포먼스 및 학습 효율에 큰 부분을 차지하는데, LVLM의 학습 데이터에는 품질 관련 문제가 있으며 이는 Hallucination을 유발하는 원인이 된다.

Data Bias

- 데이터 편향의 주요 문제 중 하나는 분포 불균형이다. 대부분의 모델이 질문에 대해 “Yes”로 대답하게끔 학습되는데, 이는 틀린 프롬프트에 대해서도 설명을 제공하려고 하는 문제로 이어진다.

- 또 다른 문제는 데이터 동질성(Data homogeneity)으로 다양한 지시(Instruction)가 부족하여 사용자의 질문에 충실하지 않고 단순히 이미지를 묘사하는 데 그치는 문제로 이어진다.

Annotation Irrelevance

- 대부분의 지시(Instruction) 데이터는 이미지 캡셔닝 또는 객체 검출 데이터로부터 LLM을 거쳐 합성된 것이다.

- 이 과정에서 생성된 데이터에는 LLM의 Hallucination이 포함되는 경우가 많고, 이는 LVLM에서 Hallucination을 촉진시킨다.

4.2 Hallucinations from Vision Encoder

- LVLM에서 주요 사용되는 CLIP의 ViT는 다양한 태스크에서 좋은 성능을 보이지만, 여전히 시각 정보를 완전히 표현하는 것에는 한계가 있다.

- 이 문제는 입력 이미지의 해상도 및 세밀한 정보를 포착하는 데 제한이 있기 때문이다.

Limited Visual Resolution

- 해상도가 높을수록 시각 인코더는 이미지로부터 객체를 더 정확하게 인식하고 세밀한 정보를 보존하여 Hallucination을 완화시킬 수 있다.

- 하지만 해상도는 연산량에 직접적으로 영향을 미치기 때문에, 대부분의 모델은 작은 해상도(224, 336)에서 학습된다.

Fine-grained Visual Semantics

- CLIP은 이미지와 텍스트 피쳐를 정렬(Align)하기 위해 대조 학습(Contrastive Learning)으로 학습된다.

- 이는 주로 큼직한, 두드러진 객체에만 집중하기 때문에, 세밀한(Fine-grained) 요소를 잘 포착하지 못한다. 따라서 Object Counting, Object Relation 등의 Hallucination이 발생하는 원인이 된다.

4.3 Hallucinations from Modality Aligning

- Connection Module은 시각 특징과 텍스트 특징의 모달리티를 정렬하기 위해서 시각 특징을 LLM의 임베딩 공간으로 투영시킨다.

- 따라서 Misalignment는 Hallucination의 핵심 원인이 될 수 있다.

Connection Module Simplicity

- 시각 정보와 텍스트 정보를 정렬시키기 위해 Linear Layer와 같은 단순한 구조가 Connection Module로 사용되는데, 이는 비용 측면에서는 유리하지만 모달 간의 정렬 정확도를 낮출 수 있고 그 결과 Hallucination을 증가킨다.

Limited Token Constraints

- Q-Former와 같이 BLIP-2, MiniGPT-4 등에서 멀티모달 정렬을 위해 사용되는 모듈은 학습 가능한 쿼리 토큰을 도입하여 이미지를 표현한다.

- 보통 토큰은 32개로 사용되는데, 이는 이미지를 표현하기에는 부족한 길이일 수 있다.

- 따라서 정보 손실이 발생할 수 있고, 이는 Hallucination으로 이어진다.

4.4 Hallucinations from LLM

- LLM은 LVLM 아키텍쳐에서 중추적인 역할로 복잡한 멀티모달 특징을 처리하는 LVLM의 성능을 향상시킨다.

- 하지만 동시에 LLM 본연의 문제인 Hallucination을 LVLM으로 전이시키는 결과를 낳는다.

Insufficient Context Attention

- 디코딩 중에, 모델이 컨텍스트의 일부분에만 집중하는 현상이다.

- 이는 시각 정보는 무시한채로 현재 생성중인 정보에만 과도하게 의존하도록 만든다.

- 또한 언어 패턴을 우선시하여 문법적으로는 유창하지만 정확하지 않은 컨텐츠를 포함한다.

- 그리고 요약 토큰에만 치우쳐져 환각이 발생하는 경우도 있다.

Stochastic Sampling Decoding

- 확률적 샘플링 디코딩은 디코딩 과정에서 무작위성을 만들어내고, LLM의 전략(Strategy) 중 하나이다.

- 이 방법은 저품질(Low-quality) 텍스트 생성을 방지하고 생성된 컨텐츠를 더 풍부하게 만든다.

- 하지만 모델에 무작위성을 도입함으로써 환각의 위험이 더 커질 수 있다.

Capability Misalignment

- 능력 불일치란 사전학습 과정에서 생성된 모델의 능력과 지시 튜닝(Instruction Tuning) 과정에서 요구하는 능력 간의 차이를 말한다.

- 이러한 불일치는 모델의 한계를 넘어서는 음답을 요구하기 때문에, 환각 발생 가능성을 높인다.

5. Mitigation of LVLM Hallucination

- 위 이미지에서 처럼, 환각 현상의 완화를 위해 다양한 방법들이 제안되었다.

- 각각의 방법들은 앞에서 분석한 원인들에 대해 맞춤화된 것들이다.

5.1 Mitigation for Data

- 훈련 데이터를 최적화하는 것은 환각을 완화하기 위한, 직접적이고 효율적인 방법이다.

- Bias와 Annotation 두 가지 측면으로 제안된다.

Bias Mitigation

- 학습 데이터의 긍정/부정 샘플을 모두 고려하는 것이다.

- CIEM은 LLM으로부터 Contrastive Question-Answer 쌍을 구축하여 Contrastive Instruction Tuning(CIT)를 수행한다.

- LRV-Instruction은 서로 다른 세가지 형태의 부정 샘플을 포함한 400,000개의 Visual Instruction Data를 제안한다.

- Ferret은 원래의 카테고리, 속성, 수량 정보를 유사한 가짜 정보로 대체하여 95,000개의 부정 샘플을 생성하는 방식을 제안한다. 이 방법은 모델의 강건성을 효과적으로 증가시켰다.

Annotation Enrichment

- 풍부하게 Annotation된 데이터셋을 구축함으로 써 LVLM이 더 정확한 시각 정보를 추출하게끔 만들어 환각을 완화한다.

- 대표적인 데이터셋으로는 M-HalDetection로, 객체의 존재 여부, 상대적 위치, 속성 정보 등 다양하게 Annotation되어있다.

- GRIT은 계층적인 공간 정보를 기반으로 한 지시문을 제공한다.

5.2 Mitigation for Vision Encoder

Scaling-up Vision Resolution

- 선행 연구에서는 이미지의 해상도를 224에서 448로 점진적으로 확대하는 방식이 유효하다는 것을 입증했다.

- 또한 InternVL은 비전 인코더를 60억 규모로 확장하고 1,664~6144 픽셀 너비의 이미지까지 처리할 수 있다.

- 하지만 이러한 접근은 대규모 데이터로 학습할 때 상당한 자원을 요구한다는 단점이 있다.

Perceptual Enhancement

- 기존의 대부분 LVLM들이 CLIP의 ViT를 비전 인코더로 사용하면서 주로 눈에 띄는(Sailent) 객체에만 집중하고 시각적 단서를 놓치는 문제를 해결하기 위한 접근이다.

- 세그멘테이션 맵, 깊이 맵 두가지를 사용한 VCode 방법, 장면 그래프(Scene graph)를 활용한 방법들이 있다.

5.3 Mitigation for Connection Module

Connection Module Enhancing

- 이 방법은 앞에서 언급했듯이, Connection Module의 제한된 표현력으로부터 유발된 환각 현상을 해결하기 위한 접근이다.

- 단일 선형 계층에서 MLP로 업그레이드하는 방법과 QLLaMA등의 방법이 있다.

Alginment Training Optimizing

- LVLM에서 시각 토큰과 텍스트 토큰 사의 간극을 줄이는 방식이다.

- 사람의 피드백을 활용한 강화학습을 통해 모달리티 간 Alignment를 수행한 연구도 있다.

5.4 Mitigation for LLM

Decoding Optimization

- Insufficient Context Attention 문제에 대응하여, 모델이 디코딩 과정에서 적절한 문맥에 집중할 수 있도록 하는 연구가 시도되고 있다.

- LVLM이 소수의 요약 토큰에 과하게 집중하고 이미지 토큰을 무시함으로써 생기는 환각 문제를 완화하기 위해 Beam Search 과정에서 가중치 기반 점수 시스템을 적용하는 매커니즘 OPERA가 있다.

Aligning with Human

- LVLM을 인간의 선호도에 맞춰 학습시키는 것으로 환각을 완화할 수 있다.

- RLHF(Reinforcement Learning from Human Feedback)으로, 인간의 선호도를 반영하는 Reward Model을 도입하여 LVLM을 인간의 선호도에 의존하게 학습하는 것이다.

5.5 Mitigation via Post-processing

- LVLM의 내부 모듈을 조작하는 방법 외에도 후처리(Post-processing)나 출력 편집(Output Editing)을 통해 환각을 완화시킬 수 있다.

- 예를 들어 LURE는 객체 환각 원인에 대한 Insight를 활용하여 MiniGPT-4 기반 Revisor Model을 학습시킨다.

- 또한 Woodpecker와 같이 학습 없이 적용 가능한 후처리 방식도 있다. 응답 내용을 정제하는 방식으로, Output Editing에 가깝다.

6. Future Directions

LVLM as Agent

- 여전히 숫자 인식 등 세밀한 정보 추론은 어렵다.

- 더 강력한 인코더 대신 시각 도구(Detector, Segmentor)를 활용한 추론 능력 학습이 유효하다.

Delving into Interpretability

- 후처리는 효과적이지만 비용이 크고 설계가 복잡하다.

- 환각의 내부 원인을 분석해 근본적인 해결책 모색이 필요하다.

- 디코딩 전략이나 모델 편집(Editing) 등이 해석 가능성과 환각 완화에 도움된다.

7. Conclusion

- LVLM은 강력한 성능을 보이지만, 환각 현상이 실질적 적용의 큰 장애물이다.

- 본 서베이는 환각의 평가 방법, 원인 분석, 완화 전략을 종합적으로 다룬다.

- 이를 통해 환각 문제 해결의 기반을 마련하고, 실제 응용 가능성을 높이는 데 기여하고자 한다.

728x90